Entdecken Sie, wie Big Data Technologien sowie Analysen & Trends den Unternehmenserfolg prägen. Ihr Leitfaden für die datengetriebene Welt.

Einführung in Big Data

Was ist Big-Data?

Big Data bezeichnet extrem große Mengen an Daten unterschiedlichster Art, die mit hoher Geschwindigkeit erzeugt werden und mithilfe komplexer Technologien analysiert werden, um Muster, Trends und Verbindungen zu erkennen, die für geschäftliche oder wissenschaftliche Erkenntnisse genutzt werden können.

Definition von Big Data und deren Relevanz in der heutigen digitalen Welt

Big Data ist ein Begriff, der weit über das Konzept riesiger Datenmengen hinausgeht. Er repräsentiert eine transformative Kraft in der modernen Geschäftswelt, indem er den Umgang mit Informationen revolutioniert und Entscheidungsfindungen auf eine zuvor ungekannte Weise datengetrieben macht.

Bei Big Data geht es um Datensätze, deren Größe oder Typ die Fähigkeit herkömmlicher Datenbanken zur Speicherung, Verarbeitung und Analyse übersteigt. Ob in Terabytes oder Exabytes bemessen, bilden diese Daten den Kern der digitalen Wertschöpfungskette, von der Markttrendprognose über Kundenanalysen bis hin zur Geschäftsoptimierung.

Ein kurzer historischer Überblick über Big Data

Die Reise zu Big Data begann mit den ersten Datenverarbeitungssystemen und nahm mit der Verbreitung des Internets und der Explosion von Online-Daten an Fahrt auf. Die Basis und Treiber dieser Entwicklung waren Technologiegiganten wie Google und Amazon, die in der Lage waren, große Datenmengen effizient zu speichern und zu durchsuchen.

Heute befinden wir uns inmitten einer kontinuierlichen Weiterentwicklung, bei der Technologien wie Cloud Computing und Maschinelles Lernen die Grenzen dessen, was mit Big Data möglich ist, stetig erweitern.

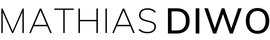

Die drei Vs von Big Data: Volumen, Variety (Vielfalt), Velocity (Geschwindigkeit)

Diese drei Vs stellen nicht nur Herausforderungen dar, sondern bieten auch große Chancen für Organisationen, die nach Möglichkeiten suchen, aus ihren umfangreichen Datenmengen Wert zu schöpfen. Um das immense Volumen zu bewältigen, sind fortschrittliche Datenmanagement- und Speichertechnologien erforderlich, die es ermöglichen, große Mengen an Daten effizient zu speichern und zugänglich zu machen.Die Vielfalt der Daten erfordert wiederum leistungsfähige Analysewerkzeuge und Algorithmen, die in der Lage sind, unterschiedlichste Datentypen zu verarbeiten und miteinander zu verknüpfen. Hierdurch können tiefergehende Einsichten gewonnen werden, die bei Entscheidungsprozessen unterstützend wirken.

Die Geschwindigkeit, mit der die Daten erfasst und analysiert werden müssen, erfordert schnelle und reaktionsfähige Systeme, die eine zeitnahe Verarbeitung ermöglichen. Dies ist besonders in Umgebungen wichtig, in denen Echtzeitentscheidungen auf Basis aktueller Informationen getroffen werden müssen, wie beispielsweise im Finanzwesen oder bei der Online-Werbung.Durch die Bewältigung dieser Herausforderungen können Organisationen nicht nur ihre operative Effizienz steigern, sondern auch neue Geschäftsmodelle entwickeln und personalisierte Kundenerfahrungen schaffen. So wird Big Data zum Treiber für Innovation und Wachstum in einer zunehmend datengesteuerten Welt.

Volumen

Der erste Baustein von Big Data ist das Volumen. Es bezieht sich auf die schiere Masse der Daten, die in der digitalen Ära anfallen. Unternehmen jeder Größe sehen sich mit Datenmengen konfrontiert, die von traditioneller Hardware kaum noch zu bewältigen sind.

Variety (Vielfalt)

Die Vielfalt von Big Data umfasst die verschiedenen Datenformate und -quellen. Dieses Spektrum reicht von strukturierten Datenbankinformationen über semi-strukturierte Dokumente bis hin zu unstrukturierten Datenströmen aus den sozialen Medien oder Sensoren.

Velocity (Geschwindigkeit)

Mit der Geschwindigkeit wird die atemberaubende Rate beschrieben, mit der Daten erzeugt und verarbeitet werden müssen. Die Fähigkeit, in Echtzeit zu agieren, ist entscheidend für die Echtzeitentscheidung und -analyse, die moderne Geschäftsprozesse erfordern.

Indem wir Volumen, Vielfalt und Geschwindigkeit als die Grundpfeiler von Big Data verstehen, können wir beginnen, das komplexe Netzwerk zu entwirren, das diese so kraftvolle und zukunftsweisende Ressource ausmacht. Im nächsten Abschnitt des Beitrags werden wir tiefer in die Technologien, die Big Data beherrschbar machen, und die Herausforderungen, die sie mit sich bringen, eintauchen.

Weitere Potenziale von Big Data

Big Data bezieht sich auf extrem große Datensätze, die durch ihre Analyse komplexe Muster und Trends aufdecken können, welche mit traditionellen Datenverarbeitungsmethoden nicht erkennbar wären. Diese Daten können aus vielfältigen Quellen stammen, wie sozialen Medien, Sensoren, digitalen Transaktionen oder Unternehmensdaten. In den letzten Jahren sind auf jeden Fall 2 weitere Punkte, sogenannte Vs dazugekommen:

Value (Wert)

Der Wert von Big Data entsteht durch die Umwandlung von Daten in Erkenntnisse, die für Geschäftsentscheidungen, operative Verbesserungen und Kundenverständnis genutzt werden können. Durch intelligente Analyse können Unternehmen Wettbewerbsvorteile erzielen, die Effizienz steigern und neue Geschäftsfelder erschließen.

Veracity (Richtigkeit)

Veracity steht für die Zuverlässigkeit und Genauigkeit von Daten. In der Welt von Big Data ist es entscheidend, dass Informationen korrekt sind, um fundierte Entscheidungen treffen zu können. Fehlerhafte oder irreführende Daten können zu falschen Schlussfolgerungen führen. Daher ist es notwendig, Techniken zur Datenbereinigung und -validierung einzusetzen, um die Veracity zu gewährleisten.

Technologien hinter Big Data

Die Faszination, die Big Data umgibt, wäre ohne die wegweisenden Technologien, die ihre Analyse und Nutzung erst ermöglichen, nicht denkbar. Fortschrittliche Lösungen in der Datenlagerung, Verarbeitung und Analyse sind die Stützpfeiler, die das Potential von Big Data Wirklichkeit werden lassen.

1. Datenlagerung: Grundstein der Big Data Architektur

Datenlagerung bildet den entscheidenden Grundstein der Big Data Architektur. Sie umfasst die systematische Sammlung und Organisation von Datenmengen, die aus einer Vielzahl von Quellen generiert werden. Moderne Datenlager sind so ausgelegt, dass sie große Volumina an strukturierten und unstrukturierten Daten effizient speichern und für Analysezwecke zugänglich machen können.

Mit dem Aufkommen von Big Data hat sich die Landschaft der Datenlagerung erweitert und umfasst nun Technologien wie Datenlakes, NoSQL-Datenbanken sowie Cloud-basierte Speicherlösungen. Diese Technologien ermöglichen es Unternehmen, mit der ständig wachsenden Flut an Informationen Schritt zu halten und daraus wertvolle Erkenntnisse zu gewinnen.

Die robuste Infrastruktur eines Datenlagers ermöglicht es, komplexe Analysen durchzuführen, Muster zu erkennen und Vorhersagen zu treffen. Dies ist entscheidend für Geschäftsentscheidungen und die Entwicklung neuer Strategien. In einer Zeit, in der Daten als das neue Öl gelten, ist eine solide Datenlagerung das Fundament, auf dem Unternehmen ihre Informationsressourcen sicher und effektiv verwalten können.

Hadoop

Apache Hadoop hat sich als Synonym für Big Data etabliert. Es ist eine Open-Source-Framework-Suite, die die Speicherung und Analyse von riesigen Datenmengen über Cluster von Commodity-Hardware ermöglicht. Hadoop besteht aus dem Hadoop Distributed File System (HDFS), das eine hohe Datenverfügbarkeit und Fehlertoleranz bietet, und YARN, einer Plattform zur Job-Scheduling und Cluster-Verwaltung.

Cloud Storage

Die Flexibilität von Cloud-basierten Speicherlösungen hat sie zu einer beliebten Wahl für die Handhabung von Big Data gemacht. Anbieter wie Amazon S3, Google Cloud Storage oder Microsoft Azure bieten skalierbaren, sicheren und erschwinglichen Speicher, der sich nahtlos mit verschiedenen Datenanalysetools und -plattformen integrieren lässt.

NoSQL-Datenbanken

NoSQL-Datenbanken wurden als Antwort auf die Begrenzungen von traditionellen relationalen Datenbanksystemen bei der Arbeit mit unstrukturierten Daten und bei Skalierbarkeitsanforderungen entwickelt. Mit Datenbanken wie MongoDB, Cassandra oder Couchbase können Unternehmen flexibel und effizient mit einer Vielzahl von Datenformaten umgehen.

2. Datenverarbeitung: Beschleunigung der Datenintelligenz

Die Beschleunigung der Datenintelligenz steht im Zentrum der modernen Datenverarbeitung. In einer Welt, in der die Datenmengen exponentiell wachsen, ist es entscheidend, Technologien und Verfahren zu entwickeln, die eine schnelle, effiziente und intelligente Analyse dieser Daten ermöglichen. Fortschritte in der Künstlichen Intelligenz, Machine Learning und automatisierten Datenanalyseverfahren haben dazu beigetragen, dass Unternehmen und Organisationen wertvolle Einsichten aus ihren Daten schneller als je zuvor gewinnen können.Durch den Einsatz von fortschrittlichen Algorithmen können Muster erkannt, Prognosen erstellt und Entscheidungen in Echtzeit optimiert werden. Dies führt zu einer verbesserten Reaktionsfähigkeit und Agilität in Geschäftsprozessen. Die Beschleunigung der Datenintelligenz ermöglicht es auch, personalisierte Erfahrungen für Kunden zu schaffen und die Effizienz in Betriebsabläufen zu steigern.Die Herausforderung liegt darin, die richtigen Werkzeuge und Strategien zu entwickeln, um mit der Geschwindigkeit und Komplexität der Daten Schritt zu halten. Unternehmen, die in der Lage sind, ihre Datenintelligenz zu beschleunigen, können sich einen entscheidenden Wettbewerbsvorteil sichern und sind besser gerüstet für die Anforderungen des digitalen Zeitalters.

MapReduce

Als Kernkomponente von Hadoop erlaubt MapReduce die Verarbeitung von großen Datensätzen durch die parallele Verarbeitung auf einem verteilten Server-Cluster. Dieser zweistufige Prozess teilt Aufgaben in kleine Arbeitspakete auf (Map) und führt die Ergebnisse dann zusammen (Reduce), um effiziente Datenanalysen zu ermöglichen.

Spark

Apache Spark ist ein leistungsstarkes Framework für Big Data Verarbeitung, das speziell für schnelle Operationen und die Verarbeitung in Echtzeit bekannt ist. Es kann bis zu 100-mal schneller als Hadoop für bestimmte Anwendungen sein und unterstützt eine breite Palette von Sprachen wie Scala, Python, Java und R.

Echtzeitverarbeitungsframeworks

Echtzeitverarbeitungsframeworks wie Apache Storm und Apache Flink ermöglichen es, Streaming-Daten nahezu in Echtzeit zu verarbeiten, was für zeitkritische Anwendungen wie Betrugserkennung oder Live-Datenmonitoring unerlässlich ist.

3. Datenanalyse: Das Herzstück der Datenwissenschaft

Datenanalyse bildet das Kernstück der Datenwissenschaft. Sie ist der Prozess, durch den Rohdaten in wertvolle Einsichten umgewandelt werden. In einer Welt, die von Informationen angetrieben wird, ermöglicht die Datenanalyse Unternehmen und Organisationen, fundierte Entscheidungen zu treffen. Sie kombiniert technische Fähigkeiten mit statistischen Kenntnissen und einem Verständnis für das jeweilige Geschäftsfeld.Durch Methoden wie Klassifizierung, Clusterbildung und Assoziationsanalyse werden Muster und Korrelationen in großen Datenmengen identifiziert. Moderne Tools und Algorithmen helfen dabei, komplexe Daten zu visualisieren und zu interpretieren. Die daraus resultierenden Erkenntnisse führen zu Optimierungen in Betriebsabläufen, zur Entwicklung neuer Produkte oder zur Personalisierung von Kundenangeboten.Die Datenanalyse ist somit nicht nur das Herzstück der Datenwissenschaft, sondern auch ein wesentlicher Treiber für Innovation und Effizienz in unserer modernen Gesellschaft.

Maschinelles Lernen und Data Mining

In der heutigen Zeit spielen sophistizierte Algorithmen des maschinellen Lernens eine zunehmend wichtige Rolle, wenn es darum geht, komplexe Muster und wertvolle Erkenntnisse aus großen Datenmengen – oft bezeichnet als Big Data – zu extrahieren. Diese Algorithmen sind in der Lage, selbstständig zu lernen und sich anzupassen, indem sie Daten analysieren und daraus Schlüsse ziehen, ohne dass sie explizit programmiert werden müssen.

Maschinelles Lernen und Data Mining sind somit entscheidende Werkzeuge in der modernen Datenanalyse, die es ermöglichen, große Datenmengen nicht nur zu verarbeiten, sondern aus ihnen einen echten Mehrwert zu schaffen. Sie sind die treibenden Kräfte hinter vielen Innovationen in verschiedenen Branchen und tragen dazu bei, die Entscheidungsfindung auf ein neues, datengestütztes Niveau zu heben.

BI-Tools

Business Intelligence (BI)-Tools veranschaulichen komplexe Daten in einer verständlicheren Form. Plattformen wie Tableau, Power BI oder Qlik Sense unterstützen Unternehmen dabei, datengetriebene Einblicke visuell zu erforschen und zu kommunizieren.Diese Technologien kreieren das Fundament, auf dem die Potenziale von Big Data erschlossen werden können. Sie ermöglichen Unternehmen, von der einfachen Datenspeicherung bis hin zur komplexen Verarbeitung und tiefgreifenden Analyse, den vollen Wert ihrer Daten zu nutzen. Im folgenden Abschnitt werden wir die Quellen und Methodiken der Datenerfassung erforschen, um zu verstehen, wie Big Data in seiner rohen Form gewonnen wird.

Big Data Quellen und Datenerfassung

Big Data Quellen und Datenerfassung sind zweifelsohne zentrale Säulen der modernen Datenanalyse. In unserer digitalisierten Welt entstehen jeden Tag unvorstellbare Mengen an Daten, deren Volumen kontinuierlich zunimmt. Diese Datenflut entspringt einer breiten Palette an Ursprüngen: von sozialen Netzwerken, die Millionen von Nutzerinteraktionen speichern, über Sensoren in Smart Devices, die Informationen in Echtzeit übermitteln, bis hin zu Transaktionsdaten des E-Commerce, die Aufschluss über Käuferverhalten geben.Die Herausforderung bei Big Data beginnt bereits bei der Datenerfassung. Hier ist wichtig, dass die Systeme in der Lage sind, die enormen Datenmengen effizient zu sammeln und zu speichern.

Arten von Datenquellen: Die Ursprünge der Datenvielfalt

Soziale Medien

Soziale Medien sind Goldgruben für Big Data. Jede Interaktion, jedes geteilte Bild und jeder Kommentar bildet eine Datenspur, die Einblicke in das Verhalten und die Vorlieben von Nutzern ermöglicht. Diese Daten sind besonders wertvoll für Marketing und Kundenbeziehungsmanagement.

Sensordaten

Das Internet der Dinge (IoT) hat Sensordaten zu einer immer wichtigeren Datenquelle gemacht. Ob in Smartphones, Wearables oder eingebettet in industrielle Maschinen, Sensoren liefern Echtzeitinformationen über Zustand und Leistung.

Transaktionsdaten

Finance und E-Commerce generieren enorme Mengen an Transaktionsdaten. Kauf- und Verkaufsaktivitäten spiegeln nicht nur wirtschaftliche Trends wider, sondern bieten auch Einsichten in Käuferverhalten und Marktdynamiken.

Methoden und Werkzeuge zur Datenerfassung: Wie Daten zu Big Data werden

Zuverlässige und effiziente Tools und Methoden sind entscheidend, um den wertvollen Datenreichtum zu heben. APIs (Application Programming Interfaces) ermöglichen die nahtlose Erfassung von Datenströmen aus sozialen Netzwerken. Web Scraping Tools extrahieren öffentlich zugängliche Daten von Websites.

Sensordaten werden oft über spezialisierte Middleware erfasst, die sie in nutzbare Formate konvertiert. Und in der Finanzwelt sorgen Transaction Processing Systems dafür, dass jede Transaktion gespeichert und verfügbar gemacht wird.

Herausforderungen bei der Datenerfassung: Zwischen Wert und Verantwortung

Datenschutz

Die Erfassung und Nutzung von persönlichen Daten sind hochsensible Themen. Datenschutzvorschriften wie die DSGVO stellen sicher, dass die Privatsphäre der Nutzer gewahrt bleibt und ihre Daten sicher gehandhabt werden.

Qualitätssicherung

Daten sind nur so wertvoll wie ihre Qualität. Falsche, unvollständige oder irrelevante Daten können Analysen verzerren und zu falschen Schlüssen führen. Qualitätssicherungsinstrumente sind daher unerlässlich, um die Integrität von Big Data zu gewährleisten.

Die Sorgfalt, mit der Unternehmen Datenquellen wählen und Daten erfassen, legt den Grundstein für den Erfolg ihrer Big Data Initiativen. Die daraus resultierenden Informationen sind das Lebenselixier datengetriebener Entscheidungen und Innovationen, die in den darauffolgenden Abschnitten näher beleuchtet werden.

Datenmanagement und -verarbeitung

Die Konvertierung roher Daten in verwertbare Einsichten ist ein komplexer Prozess, der ein durchdachtes Datenmanagement und fortschrittliche Verarbeitungsverfahren erfordert. In diesem Abschnitt beleuchten wir die wesentlichen Schritte zum effektiven Umgang mit Big Data, die für Unternehmen aller Branchen grundlegend sind.

Datenintegration und -bereinigung: Eine solide Datenbasis schaffen

Datenintegration

In einer Welt, in der Daten aus einer Vielzahl von Quellen und in verschiedenen Formaten strömen, ist die Integration zu einer zentralen Herausforderung geworden. Die Datenintegration befasst sich mit der Zusammenführung dieser unterschiedlichen Daten, um ein umfassendes und einheitliches Bild zu schaffen. ETL-Prozesse (Extraktion, Transformation, Laden) spielen dabei eine Schlüsselrolle, indem sie Daten extrahieren, umwandeln und in ein zielgerichtetes System integrieren.

Datenbereinigung

Die Qualität von Big Data ist nur gewährleistet, wenn Inkonsistenzen und Fehler beseitigt werden. Datenbereinigung ist daher ein kritischer Schritt, um Duplikate zu entfernen, fehlende Werte zu ergänzen und Ungenauigkeiten zu korrigieren. Erst eine solche Bereinigung macht die Datenanalyse zuverlässig und aussagekräftig.

Datenmodellierung und -archivierung: Struktur für die Ewigkeit

Datenmodellierung

Datenmodellierung umfasst das Design von Datenbankstrukturen, die Big Data effizient speichern und für Analysen zugänglich machen. Modellierungstechniken wie das ER-Modell (Entity-Relationship-Modell) oder dimensionales Modellieren sind wesentlich für das Verständnis und die effektive Verarbeitung von datengetriebenen Beziehungen und Hierarchien.

Datenarchivierung

Eine langfristige Datenhaltung erfordert Strategien zur Datenarchivierung, um Compliance-Anforderungen zu erfüllen und historische Daten für zukünftige Analysen zu bewahren. Archivierungslösungen müssen sowohl zugänglich als auch sicher sein, um den lückenlosen Zugriff auf Informationen über Jahre hinweg sicherzustellen.

Datenschutz und -sicherheit: Vertrauen in der Welt der Daten

Der Schutz der Privatsphäre und der sichere Umgang mit Daten sind entscheidende Faktoren, um das Vertrauen der Kunden und Partner zu erhalten und regulatorische Auflagen zu erfüllen. Datenschutzgesetze wie die Europäische Datenschutz-Grundverordnung (DSGVO) verlangen strenge Maßnahmen zur Datensicherheit, während Technologien wie Verschlüsselung und Zugriffskontrollen dazu beitragen, Datenschutzanforderungen zu erfüllen und Daten vor unbefugtem Zugriff zu schützen.Effektives Datenmanagement und sorgfältige Verarbeitung sind der Schlüssel, um Big Data von einer Herausforderung in einen wahren Geschäftsvorteil zu verwandeln. Im nächsten Kapitel werden wir die Techniken und Methoden erkunden, die angewandt werden, um aus Big Data bedeutungsvolle Analysis zu generieren und sie zu einem integralen Bestandteil der strategischen Unternehmensentscheidung zu machen.

Analyse und Nutzung von Big Data

Die Analyse von Big Data ist der Brennpunkt, an dem rohe Daten in wertvolle Erkenntnisse umgewandelt werden. Die fortschrittlichen Analysemethoden geben nicht nur Aufschluss über aktuelle Zustände, sondern ermöglichen auch Prognosen und Handlungsempfehlungen für die Zukunft. Durch die Integration von Big Data in operationelle Prozesse können Unternehmen eine data-driven Kultur etablieren, die sie im Wettbewerb entscheidend voranbringt.

Analysemethoden (Big Data Analytics): Von der Beschreibung zur Vorschrift

Deskriptive Analyse

- Am Anfang des Analyse-Spektrums steht die deskriptive Analyse. Sie dient dazu, vorhandene Daten zu kategorisieren, zu charakterisieren und zu klassifizieren, um einen Überblick über vergangene Leistungen und den aktuellen Zustand eines Unternehmens zu erlangen.

Prädiktive Analyse

- Die prädiktive Analyse geht einen Schritt weiter, indem sie historische Daten verwendet, um zukünftige Ereignisse vorherzusagen. Durch den Einsatz statistischer Modelle und maschinellen Lernens können Unternehmen wahrscheinliche zukünftige Szenarien und Trends erkennen.

Präskriptive Analyse

- Die präskriptive Analyse ist die Spitze des Big Data-Analysemodells und nutzt die Erkenntnisse aus der deskriptiven und prädiktiven Analyse, um konkrete Handlungsempfehlungen auszusprechen. Sie hilft Unternehmen, die besten Entscheidungen für zukünftige Strategien zu treffen und Prozesse zu optimieren

Case Studies: Big Data in Aktion

Erfolgsstories veranschaulichen, wie Big Data branchenübergreifend genutzt wird. Einzelhändler optimieren ihre Lagerbestände durch prädiktive Analysen des Kaufverhaltens.

Finanzinstitute erkennen und verhindern Betrug durch Echtzeit-Datenanalyse. Gesundheitsdienstleister verbessern die Patientenversorgung mit personalisierten Behandlungsplänen basierend auf der Auswertung von medizinischen Big Data. Diese und viele weitere Beispiele zeigen, wie die Anwendung von Big Data-Analysen zu signifikanten Verbesserungen und Innovationen führt.

Tools und Techniken für Datenvisualisierung und -interpretation

Datenvisualisierung

- Der Einsatz von Datenvisualisierungstools wie Tableau, Microsoft Power BI oder Qlik erleichtert das Verständnis komplexer Datenzusammenhänge. Sie transformieren große Datenmengen in leicht verständliche Grafiken, Diagramme und Heatmaps, die es auch Nicht-Experten ermöglichen, Trends und Muster zu erkennen.

Interpretationstechniken

- Techniken der Dateninterpretation reichen von traditionellen statistischen Methoden bis hin zu aufkommenden Ansätzen des maschinellen Lernens und künstlicher Intelligenz. Diese ermöglichen es, verborgene Zusammenhänge zu extrahieren und zu verstehen, und liefern damit den Schlüssel für datengetriebene Entscheidungen und Strategien.Big Data-Analysen sind ein machtvolles Instrument in der Hand moderner Unternehmen. Sie erlauben es, aus einem Meer von Daten, echte Einblicke zu gewinnen, vorausschauend zu planen und zielgerichtete Aktionen zu setzen. Im folgenden Abschnitt befassen wir uns mit der Praxis: Wie und wo wird Big Data konkret eingesetzt, um betriebliche Abläufe zu verbessern und Kunden besser zu verstehen?

Big Data in der Praxis

Big Data hat die Art und Weise, wie Unternehmen arbeiten und strategische Entscheidungen treffen, grundlegend verändert. Durch beispiellose Einblicke in interne und externe Prozesse hat Big Data zu neuen Innovationen und Effizienzsteigerungen in einer Vielzahl von Industrien geführt.

Einsatzbereiche von Big Data: Transformative Kraft in Unternehmen

Geschäftsoptimierung

Unternehmen setzen Big Data ein, um ihre Operationen zu verfeinern und zu optimieren. Sie analysieren Produktionsprozesse, Supply-Chain-Management und Kundeninteraktionen, um Ineffizienzen zu entdecken und Abläufe zu straffen. Mit der Hilfe von Big Data können sie schneller auf Marktveränderungen reagieren und die Kundenzufriedenheit erhöhen.

Risikomanagement

Big Data ist ein mächtiges Werkzeug, um Risiken zu erkennen, zu beurteilen und zu mindern. Die Analyse von großen Mengen an historischen Daten hilft bei der Vorhersage potenzieller zukünftiger Risiken und deren Wahrscheinlichkeitsbewertung. Finanzinstitutionen nutzen Big Data zum Beispiel, um Kreditrisiken einzuschätzen und Betrugsversuche zu identifizieren.

Kundenanalytik

Ein tieferes Verständnis der Kunden ist der Schlüssel zum Erfolg in allen Branchen. Big Data ermöglicht eine detaillierte Kundenanalyse durch die Bewertung von Kaufmustern, Verhaltensdaten und Feedbackschleifen. Dieses Wissen hilft Unternehmen, personalisierte Marketingkampagnen zu entwickeln und Kundenloyalität zu fördern.

Big Data und Künstliche Intelligenz: Eine symbiotische Beziehung

Die Verbindung von Big Data mit Künstlicher Intelligenz (KI) hat das Potenzial für zahlreiche innovative Anwendungen ausgeschöpft. KI-Modelle benötigen große Mengen an Trainingsdaten, um Muster zu erkennen und zu lernen. Big Data bildet die perfekte Grundlage dafür und ermöglicht es Künstlicher Intelligenz, präzise Vorhersagen zu treffen und intelligente Entscheidungen zu unterstützen.

Beispiele für Innovationen durch Big Data

Die Auswirkungen von Big Data auf Innovationen sind tiefgreifend und weitreichend. Im Gesundheitssektor unterstützt Big Data die Forschung und Entwicklung neuer Medikamente und Therapien durch Analyse genetischer und klinischer Daten. Im Einzelhandel revolutioniert die Analyse von Kundenverhalten und präferenzen das Einkaufserlebnis durch maßgeschneiderte Empfehlungen. Und in der Städteplanung führen Big Data-Analysen zu smarteren, nachhaltigeren und lebenswerteren Städten durch die Optimierung von Verkehrsströmen und Energieverbrauch.Big Data hat das Potential, zu einem Eckpfeiler für den Erfolg in unserer modernen Geschäftswelt zu werden. Es treibt nicht nur die Effizienz und Produktivität voran, sondern fungiert auch als Katalysator für neue Geschäftsmodelle und -strategien, die in den folgenden Abschnitten weiter ausgeführt werden.

Die Zukunft von Big Data

Die Reise von Big Data hat gerade erst begonnen. Mit dem schnellen technologischen Fortschritt und der immer weiter zunehmenden Datenmenge stehen wir am Anfang einer Ära, in der Big Data alle Aspekte unseres Lebens beeinflussen wird. Seine Zukunft ist geprägt von aufkommenden Trends, Herausforderungen und Chancen.

Trends und Entwicklungsprognosen: Uns erwartet eine vernetzte Welt

Internet der Dinge (IoT)

Das Internet der Dinge ist dabei, eine Welt zu schaffen, in der Alltagsobjekte Daten sammeln und austauschen, und Big Data ist die zentrale Ressource, die diese Interaktionen ermöglicht. Von smarter Haustechnik über vernetzte Fahrzeuge bis hin zu Industrie 4.0 – IoT-Geräte erzeugen eine ständig wachsende Flut von Daten, die neue Möglichkeiten für intelligente Systeme und Prozessoptimierungen bieten.

Edge Computing

Edge Computing stellt eine Antwort auf die enormen Datenmengen und die Notwendigkeit schnellerer Verarbeitung dar. Indem Daten nahe an der Quelle verarbeitet werden, reduzieren sich Latenzzeiten und Bandbreitenanforderungen, was die Effektivität von Echtzeitanalysen und -entscheidungen maßgeblich steigert.

Cloud Computing

Die Kombination aus Cloud Computing und Big Data bietet eine leistungsstarke Plattform für die Verarbeitung und Analyse riesiger Datenmengen in Echtzeit. Unternehmen können dadurch agiler werden und schneller auf Veränderungen reagieren. Die Cloud stellt die benötigte Infrastruktur bereit, während Big Data die Einsichten liefert, die zu einem besseren Verständnis des Geschäfts und zur Innovationsförderung.

Auswirkungen auf Arbeitsplätze und Fähigkeiten: Die Anforderungen der neuen Datenwelt

Die Digitalisierung und Big Data Transformation verändern die Anforderung an Arbeitsplätze und die benötigten Fähigkeiten. Data Scientists, Data Engineers und Business Analysts sind gefragter denn je. Ihnen gemeinsam ist die Notwendigkeit eines tiefen Verständnisses von Datenanalysen, statistischen Methoden und maschinellem Lernen. Gleichzeitig müssen bestehende Berufsgruppen umschulen und neue digitale Kompetenzen erlernen, um in der datengetriebenen Welt bestehen zu können.

Ethik und Regulierung von Big Data: Verantwortung im Zeitalter der Daten

Ethik

Mit dem wachsenden Einfluss von Big Data steigen auch ethische Bedenken. Fragen der Privatsphäre, des Datenschutzes und der fairen Datennutzung rücken in den Fokus. Die ethische Nutzung von Big Data erfordert transparente Richtlinien und eine verantwortungsbewusste Entscheidungsfindung.

Regulierung

Gesetze und Vorschriften wie die DSGVO stellen sicher, dass mit Big Data verantwortlich umgegangen wird. Sie geben einen Rahmen vor, innerhalb dessen die Sammlung, Verarbeitung und Analyse von Daten stattfinden muss, und schützen so die Rechte der Individuen.Die Zukunft von Big Data ist eine Welt voller Chancen, aber auch Herausforderungen. Die Trends deuten auf eine zunehmend datenorientierte und vernetzte Zukunft hin, die unser privates und berufliches Leben maßgeblich prägen wird. In diesem dynamischen Umfeld werden ethische Überlegungen und regulative Maßnahmen entscheidend sein, um das Vertrauen und die Sicherheit in Bezug auf Big Data zu wahren. Im nächsten Abschnitt beschäftigen wir uns mit den Herausforderungen und der Kritik, die Big Data begleiten, und wie sie gemeistert werden können.

Eine Big Data Strategie entwickeln

Die Entwicklung einer Big Data Strategie stellt eine fundamentale Anforderung in der heutigen digitalen Wirtschaft dar. Um aussagekräftige Entscheidungen treffen zu können und einen Wettbewerbsvorteil zu erlangen, ist es entscheidend, dass Unternehmen eine fundierte Big Data Strategie entwickeln und umsetzen. Bevor eine solche Strategie entwickelt wird, sollte ein Unternehmen zunächst seine Ziele und Prioritäten klar definieren.

Dann erfordert die Entwicklung einer effektiven Big Data Strategie eine detaillierte Analyse der verfügbaren Daten, der benötigten Daten und der besten Methoden zur Sammlung, Lagerung und Analyse dieser Daten. Das Herzstück einer jeden Big Data Strategie sollte das Verständnis der geschäftlichen Anforderungen und Ziele sein. Die Frage, welche Daten benötigt werden, um diese Anforderungen zu erfüllen, ist von entscheidender Bedeutung. Die Antwort auf diese Frage hilft dabei, die richtigen Werkzeuge und Technologien für die Datenerfassung und -analyse zu bestimmen.

Eine effektive Big Data Strategie sollte auch die Sicherheits- und Datenschutzanforderungen berücksichtigen. Daten haben einen hohen Wert und sind häufig das Ziel von Cyberattacken. Daher muss eine solide Sicherheitsarchitektur Teil jeder Big Data Strategie sein. Neben technischen Aspekten ist es auch notwendig, auf organisatorischer Ebene Veränderungen zu berücksichtigen. Die Implementierung von Big Data kann zu einer Umgestaltung von Geschäftsprozessen führen und erfordert gegebenenfalls eine Anpassung der Unternehmenskultur.

Es ist daher wichtig, alle Beteiligten in die Entwicklung und Umsetzung der Big Data Strategie mit einzubeziehen. Letztlich ist es wichtig zu verstehen, dass eine Big Data Strategie kein einmaliges Projekt ist, sondern ein fortlaufender Prozess, der ständige Überwachung, Auswertung und ggf. Anpassung erfordert, um den sich stetig ändernden geschäftlichen Bedürfnissen anzupassen und den maximalen Nutzen aus den verfügbaren Daten zu ziehen.

Herausforderungen und Kritik

Während Big Data zahlreiche Möglichkeiten eröffnet, bringt es auch eine Reihe von Herausforderungen und kritischen Fragen mit sich. Datenschutzbedenken, potenzielle Verzerrungen in den Daten und die Umweltauswirkungen der digitalen Infrastruktur sind nur einige der Themen, die Unternehmen und Gesellschaften weltweit adressieren müssen.

Datenschutzbedenken und die Rolle der Regulierung

Datenschutz

Die Sammlung und Analyse großer Datenmengen rufen Bedenken hinsichtlich des Schutzes persönlicher Informationen hervor. Wie können Unternehmen sicherstellen, dass die Privatsphäre gewahrt bleibt, während sie gleichzeitig wertvolle Datenanalysen durchführen?

Regulierung

Regulierungen wie die EU-Datenschutz-Grundverordnung (DSGVO) spielen eine entscheidende Rolle bei der Sicherstellung des Datenschutzes. Sie geben vor, wie mit personenbezogenen Daten umzugehen ist und geben Bürgerinnen und Bürgern Kontrolle über ihre Informationen. Unternehmen weltweit stehen vor der Herausforderung, Compliance zu gewährleisten und gleichzeitig den Wert von Big Data zu nutzen.

Umgang mit Bias und Qualität von Big Data

Bias

Verzerrungen (Biases) in Big Data können zu Diskriminierung und ungerechten Entscheidungen führen. Sie entstehen oft schon bei der Datenerhebung oder durch vorurteilsbehaftete Algorithmen des maschinellen Lernens. Ein bewusster und reflektierter Umgang mit Daten ist notwendig, um Bias zu erkennen und zu minimieren.

Datenqualität

Die Qualität der Daten bestimmt die Güte der Insights. Ungenaue, unvollständige oder irrelevante Daten führen zu fehlerhaften Ergebnissen und können Unternehmen in die Irre führen. Eine stetige Prüfung und Bereinigung von Big Data ist entscheidend, um valide und zuverlässige Analysen sicherzustellen.

Nachhaltigkeitsaspekte bei der Speicherung und Verarbeitung von Big Data

Die Infrastrukturen, die Big Data unterstützen, verbrauchen erhebliche Mengen an Energie und Ressourcen. Nachhaltigkeit wird daher zu einem immer wichtigeren Thema:

Energieeffizienz

Datenzentren, die Big Data speichern und verarbeiten, sind große Energieverbraucher. Innovationen in der Kühlsystemtechnologie und der Einsatz erneuerbarer Energiequellen sind wesentlich, um die ökologischen Fußabdrücke zu reduzieren.

Ressourcennutzung

Die Herstellung und Entsorgung der Hardware, die für Big Data-Analysen benötigt wird, beansprucht wertvolle Ressourcen. Effizientere Hardware und Recyclingkonzepte sind erforderlich, um den Nachhaltigkeitsanforderungen gerecht zu werden.

Die Herausforderungen, die Big Data mit sich bringt, sind komplex und multi-dimensional. Mit der fortschreitenden Entwicklung in der Datenwissenschaft kommen neue Lösungsansätze auf, die Datenschutz, Qualität und Nachhaltigkeit im Umgang mit Big Data verbessern. In der abschließenden Betrachtung werden wir zusammenfassen, wie Big Data die moderne Geschäftswelt und die Gesellschaft bereits verändert hat und welche strategischen Schritte Unternehmen für eine erfolgreiche Zukunft setzen sollten.

Fazit zu Big Data

Die Expedition durch die weite und dynamische Landschaft von Big Data nähert sich ihrem Ende. Wir haben die Grundlagen erkundet, die Technologien betrachtet, die ihre Analyse ermöglichen, und die mannigfaltigen Anwendungsmöglichkeiten, Herausforderungen und Zukunftsperspektiven von Big Data beleuchtet. Es ist Zeit, die wesentlichen Erkenntnisse zusammenzufassen und daraus Handlungsempfehlungen für Unternehmen abzuleiten.

Zusammenfassung der wichtigsten Punkte

Big Data ist ein Phänomen, das durch die immensen Datenmengen, die heute generiert und verarbeitet werden, definiert wird. Technologien wie Hadoop und moderne Analysemethoden ermöglichen es, diese Daten zu nutzen, um tiefe Einblicke in Unternehmensprozesse zu erlangen und fundierte Entscheidungen zu treffen. Gleichzeitig bringt Big Data vielfältige Herausforderungen mit sich, darunter Datenschutzbedenken, der Umgang mit Verzerrungen und ethische Aspekte der Datennutzung.

Handlungsempfehlungen und Strategien für Unternehmen

Für Unternehmen, die in der Ära von Big Data erfolgreich sein wollen, lautet die Devise: Erkenne die Macht der Daten und nutze sie verantwortungsbewusst.

- Investieren Sie in die richtigen Technologien und das Know-how zur Datenanalyse.

- Etablieren Sie strenge Datenschutz- und Sicherheitsrichtlinien, um Compliance sicherzustellen und das Vertrauen Ihrer Kunden zu wahren.

- Schaffen Sie eine Kultur der Datenkompetenz in Ihrem Unternehmen, um die Chancen, die Big Data bietet, voll auszuschöpfen.

- Seien Sie sich der ethischen Implikationen bewusst, die mit der Nutzung von Big Data einhergehen, und handeln Sie entsprechend.

- Bleiben Sie offen für neue Entwicklungen im Bereich Big Data, um Wettbewerbsvorteile nicht nur zu erhalten, sondern auszubauen.

Bedeutung von Big Data für die Zukunft

Big Data ist weit mehr als nur ein Trend. Es ist ein entscheidender Bestandteil der digitalen Transformation, der alle Bereiche unseres Lebens beeinflusst und prägt. Unternehmen, die die Zeichen der Zeit erkennen und in die Fähigkeit investieren, Big Data intelligent zu nutzen, werden die Zukunft maßgeblich mitgestalten. Sie werden in der Lage sein, Innovationen voranzutreiben, den Markt zu verstehen und auf Veränderungen schneller und effektiver zu reagieren.In einer Welt, die von Daten durchdrungen ist, werden jene, die diese Ressource verantwortungsbewusst und strategisch einsetzen, als Sieger hervorgehen. Big Data ist das neue Zeitalter der Information – und es ist an der Zeit, dieses Zeitalter aktiv mitzugestalten.Um das Verständnis für Big Data weiter zu festigen und eine Grundlage für die Vertiefung in spezifische Themenbereiche zu bieten, schließt dieser Blogbeitrag mit einem Glossar der wichtigsten Begriffe im Big Data-Kontext und einer Auswahl an Ressourcen für eine weiterführende Beschäftigung mit dem Thema.